-

En nee, ik ga niet in een bakwagen wonen.. Inmiddels zijn we verhuisd naar onze nieuwe woning. Dat betekent dat we het huis dat we de afgelopen jaren hebben geoptimaliseerd voor onze leefwijze achter ons hebben gelaten. Nu mogen we in het nieuwe huis weer aan de slag met het inregelen van de verlichting, automatisering…

-

Na de afgelopen twee jaar met volle tevredenheid gebruik te hebben gemaakt van onze Quatt Hybride-oplossing, staat voor komende maand een verhuizing op het programma. Het nieuwe huis is nu nog voorzien van een cv-installatie uit 2004, dus dat is een mooi blank canvas om nog een keer door het hele proces van verduurzaming heen…

-

Mijn werkveld is Security & Compliance. Ik heb een achtergrond in Management, Economie en Recht en heb jarenlang technische rollen in de IT vervuld. Programmeren was voor mij altijd een hobby; ik ben er niet uitzonderlijk goed in, maar ik heb wel eens een succesvolle web‑game gebouwd. Toen moest ik alles zelf leren en schrijven. Inmiddels zijn…

-

Eerder schreef ik over het belang en de positie van Security Awareness (zie mijn artikel). Een belangrijk aandachtspunt is dat we samen met de operationele afdelingen naar hun processen moeten kijken. Pas als we begrijpen wat zij doen, kunnen we passende technische én awareness-stappen nemen om een proces écht veiliger te maken. Vandaag neem ik…

-

Security Awareness e-learnings en Phishing simulaties werken niet en stompen gebruikers alleen maar af waardoor het risico mogelijk juist vergroot wordt met de inzet van deze tools. Met enige regelmaat zien we dit soort berichten voorbijkomen op LinkedIn. En alhoewel ik het hier niet volledig mee eens ben zit er wel een kern van waarheid…

-

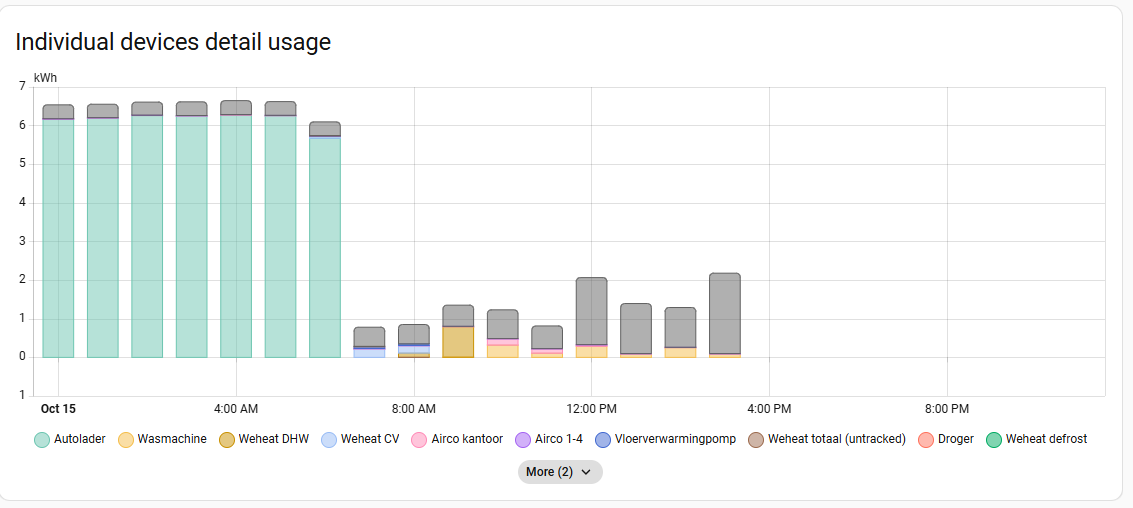

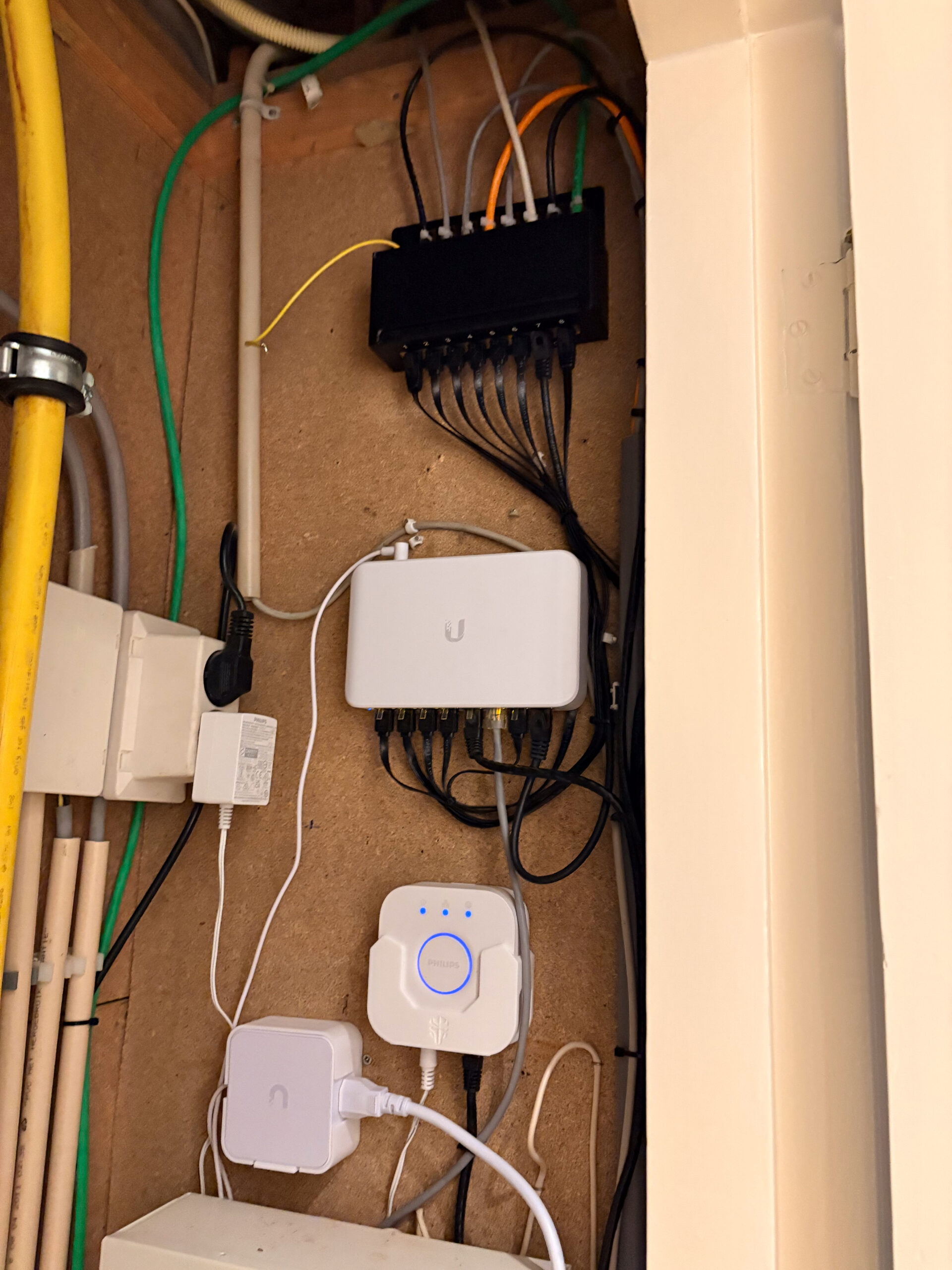

In mijn eerdere berichten heb ik al eens uitgelegd hoe ik Home Assistant gebruik om onder andere de vloerverwarmingpomp aan te sturen en de statistieken van mijn Quatt warmtepomp bij te houden. Met Home Assistant kan ik alle apparaten op een efficiënte manier automatiseren en monitoren – dat geldt ook voor de verwarming. Recentelijk heb…